获取硅基流动API

目前市面上稳定的云服务商已经不少,这里我推荐一家自己用起来体验不错的——硅基流动。硅基流动是为数不多能够稳定提供DeepSeek 671B满血版服务的公司,而且体验相当丝滑。

注册链接在这里:https://cloud.siliconflow.cn/i/Bdsoj1D6

注册之后,应该账户里默认会赠送2000万tokens,这个额度已经可以使用LLM很久了。另外充值的话调用模型还可以走一些专线提供更稳定的服务,价格也很便宜,我用了几天的DeepSeek还没花掉5毛钱。

获取API:

- API的基础链接就是:https://api.siliconflow.cn

- API key(密钥):进入 https://cloud.siliconflow.cn/account/ak 页面,复制即可

好了,我们就做好了API方面的准备!下面配合客户端,就可以直接使用了。

我们可以先去模型广场浏览一下有哪些模型,除了DeepSeek系列之外,还有知名的Qwen系列,也很不错:

注意,模型的名称,就是Model ID。

(顺便提一句,大家可以注意到,DeepSeek模型是部署在华为昇腾系列芯片上的。除了硅基流动,国内很多厂商也在使用昇腾服务,他们提供的稳定的DeepSeek推理服务,再一次证明了国产芯片的实力。据悉,目前昇腾芯片的性能已经超越了A100,接近H100了。所以,大家多多使用这些服务,不仅是为了自己的需求,也能为国产芯片积累更多宝贵的研发经验! )

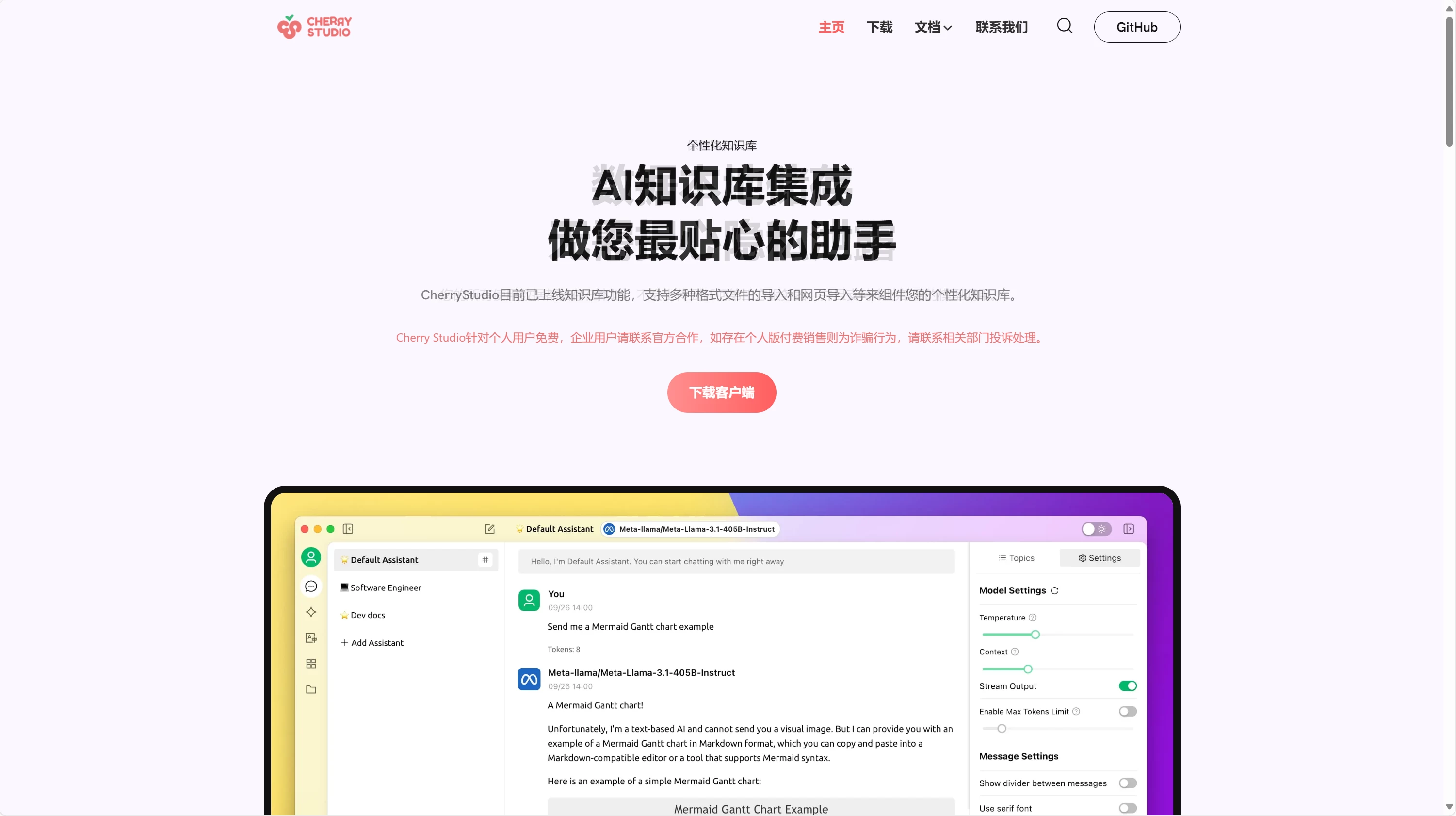

本地Cherry-Studio客户端

Cherry-Studio(https://cherry-ai.com/)是一个已经被大家广泛使用的AI客户端,里面功能十分强大,支持LLM对话、绘图等,可以接入自己的知识库。

Cherry-Studio(https://cherry-ai.com/)是一个已经被大家广泛使用的AI客户端,里面功能十分强大,支持LLM对话、绘图等,可以接入自己的知识库。

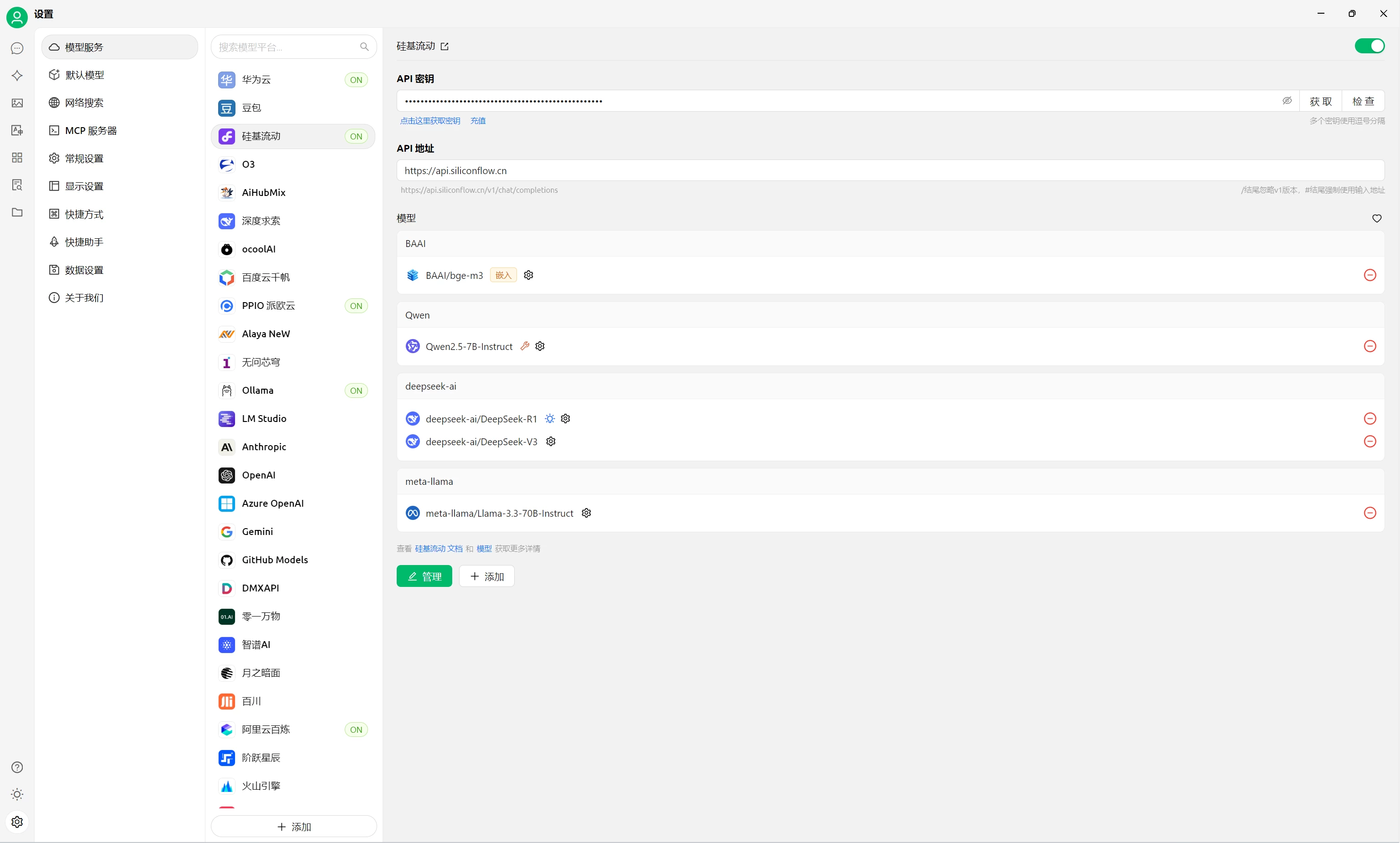

第一步,就是去官网下载客户端,安装完毕之后,点击“设置(Setting)”,找到硅基流动(Siliconflow),把上面的API链接和Key输进去:

如果想添加更多的模型,可以通过这里进行添加:

如果想添加更多的模型,可以通过这里进行添加:

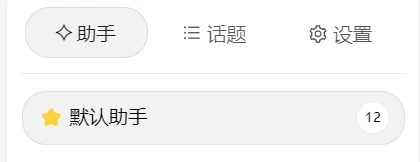

好了,添加了模型,就可以直接点击左上角的对话按钮,开启对话了,这里需要区分的是助手(assistant)和话题(topics):

助手即你可以个性化地设置不同的使用场景,写一些专用的提示词,或者使用不同的模型。配置好助手之后,就可以根据场景来选择对应的助手,不用每次重新选模型和提示词。

话题是附属在每个助手下面的,相当于你跟这个助手的一个聊天历史。

好了,完成上述设置,你应该就可以开始跟DeepSeek聊天了!

比方本文开头的那一段,就是DeepSeek V3现场帮我润色的:

高级设置: 为了更好的生成效果,DeepSeek官方给出了推荐参数:温度设为0.6,top-p设为0.95。另外,硅基流动这里对于R1模型的单次信息长度16K,所以可以在助手那里进行右键设置:

本地 ChatBox 客户端

ChatBox也是一个功能强大的本地客户端(https://chatboxai.app/zh),配置方法跟Cherry-Studio类似。

如果你掌握了Cherry-Studio的配置方法,这个应该也很容易配置,所以这里不再赘述,只是告诉大家还有这么个工具,可以根据自己的偏好进行选择。

发表回复